Solicite Ahora

Solicite Ahora

y corporativo.

con

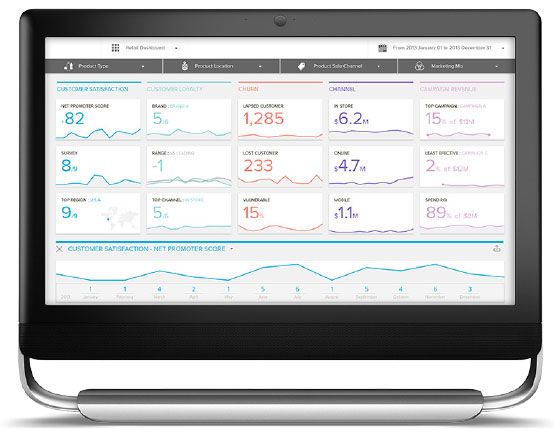

Pentaho: piensa en grande

Pentaho se ha desmarcado como una herramienta poderosa en la integración de todo tipo de datos, en el manejo de grandes volúmenes de información y en la explotación, visualización y mejor aprovechamiento de toda esa masa de datos que se está generando. Los conceptos de “Governed Data Delivery”, “Streamlined Data Refinery” y “Data Lake”, que están íntegramente relacionados, han sido impulsados desde Pentaho, creando todo una solución que permite a las empresas pensar en grande.

En EGS GROUP entregamos una metodología de consultoría de Inteligencia de Negocio que permite realizar un acabado estudio de la información de los sistemas de nuestros clientes, con la finalidad de poder entregar información que jamás habían imaginado, en tiempos insuperables.

Este mecanismo consta de funciones como,

- Big Data: grandes volúmenes de datos.

- Analítica masiva: usuarios Ilimitados.

- Analítica predictiva: PDI, Weka y R integrados.

- Mayor retorno: crear valor con menos inversión.

- Integración: Buscar las fuentes de información para generar una base normada de estudio que permita conocer en el inmediato plazo la información que el cliente busca, usando como base tablas de base de datos, Excel, Archivos de Texto, XML, Access, etc. Y usar cualquier mécanismo de salida que el cliente requiera.

- Diagramación: Se realiza un diseño de datos para generar un modelo multidimensional que permita una rápida navegación por los datos y la obtención de reportes.

- Publicación: La información es publicada en un servidor Web que permite en forma gráfica navegar y crear vistas de análisis.

Para esta importante área de nuestra compañía, EGS GROUP ha seleccionado Pentaho Corporation como nuestra representación a nivel nacional,

Streamlined Data Refinery

- Usa Hadoop como un concentrador para procesar data estructurada y no estructurada.

- Mezcla y refina diversos tipo de data para generar su correspondiente modelo.

- Empodera a usuarios finales, con autorización de IT, para escoger conjuntos de data según su fecha y contenido.

- Modela, publica y carga automáticamente el conjunto de datos en una base de datos analítica para realizar análisis interactivo de alto desempeño.